Mais um mês acaba e, como sempre, lembramos a importância de manter um backup confiável e protegido!

Confiável porque o backup, apesar de ser uma rotina automatizada, precisa ser checado e testado regularmente. Há caminhos que mudam, novas pastas são criadas, outras deixam de ser importantes... Por isso é preciso estruturar um mapa consistente de conteúdo e certificar-se que todas as informações importantes estão cobertas pela cópia de segurança.

Testado, porque não são raras as vezes em que os dados não chegam íntegros ao backup e, quando realmente são necessários, a decepção é arrasadora!

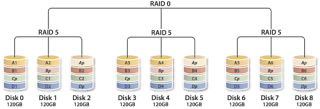

RAID, fontes redundantes e balanceamento de carga não substituem o backup...As tecnologias que asseguram o uptime dos servidores facilitam muito a gerência de TI, mas não substituem o backup!

RAID, como

já comentamos em postagem anterior, é uma tecnologia fantástica. Permite que um servidor mantenha-se acessível mesmo durante uma falha de I/O.

Fontes redundantes também visam manter um servidor operante, mesmo que uma das fontes de alimentação (uma das origens de energia) venha a ser desligada.

Esse recurso é crucial em modelos onde a energia seja fornecida por duas vias distintas, em especial por dois no-breaks alimentados por concessionárias diferentes.

Balanceamento de carga, além de manter o servidor online no caso de pane em um dos links, ainda traz ganhos quando ambos estiverem ativos, pois permitirá distribuir o tráfego de rede por caminhos físicos individualizados.

Nenhuma dessas tecnologias assegura a integridade das informações no caso de acidentes, sabotagens, desastres naturais e tantos outros riscos que envolvem a disponibilidade de uma aplicação.

Desastres acontecem...Em geral cultivamos um pensamento otimista e acreditamos que problemas nunca afetarão nossas operações. Porém, se considerarmos que as informações de uma empresa são seu ativo mais precioso, é preciso prever o pior e planejarmos um processo de backup para que essas informações estejam seguras fora do nosso ambiente de trabalho.

Chuvas na região serrana...No verão de 2011, quando deslizamentos de encostas assolaram a região serrana do RJ, diversas empresas foram afetadas e, muitas delas, tiveram suas instalações inundadas e destruídas.

As empresas que mantinham um backup consistente enfrentaram problemas, mas conseguiram restabelecer o acesso aos dados em pouco tempo.

Adquirir um novo servidor e providenciar um link em outra cidade é algo simples de se obter em poucos dias. Se o gestor dessas informações configurar um novo servidor e restaurar um backup atualizado, terá alcance às suas informações em tempo.

Até o Cloud da Amazon caiu...A computação em nuvem vem ganhando cada vez mais destaque e, como toda tecnologia que ganha ares de celebridade, é alardeada como a cura para todos os problemas!

É notório que o serviço de cloud da Amazon está entre os melhores do mundo e, mesmo assim, em abril de 2011 o serviço ficou

cinco dias fora do ar, afetando centenas de clientes e acarretando perda de informação para alguns (o número de clientes prejudicados não foi divulgado e há um grande esforço em manter esse número em sigilo).

Vale lembrar que o serviço EC2 da Amazon segue a filosofia de distribuir a nuvem entre datacenters geograficamente independentes (veja o exemplo a seguir para entender o que acontece quando a nuvem inteiro fica em apenas 1 datacenter) e, mesmo assim, o serviço caiu!

Os clientes que mantinham cópia de seus dados em local seguro tiveram a opção de aguardarem o sistema voltar e, se o problema persistisse, poderiam injetar seus dados em uma nuvem concorrente e restabelecerem seus sistemas. Já quem não tinha...

Pane elétrica na Alog-RJ...Mesmo contando com no-breaks inteligentes e geradores plenamente funcionais, em julho de 2011 o datacenter da ALOG no RJ sofreu uma pane elétrica que acarretou em 2 dias de desligamento e inúmeras perdas de dados com corrupção de bancos de dados!

Diversas empresas mantinham infraestrutura no datacenter e, durante 2 dias, somente aquelas que possuíam um backup confiável conseguiram levantar seus serviços em outro datacenter e sustentarem suas aplicações online.

Nós mesmos passamos por essa situação!

Alguns de nossos serviços rodam em servidores que ficam nesse datacenter e, quando ocorreu o desastre elétrico, migramos os sites para nossa rede interna e levantamos com nosso backup. Para nossos clientes e funcionários nossas atividades operacionais passaram despercebidas, sendo notada apenas uma lentidão, já que nosso link interno não era tão largo.

Esse exemplo mostra que um servidor com fontes redundantes, diversos no-breaks e balanceamento de carga não valeria de nada em um desastre elétrico como esse!

Explosão em restaurante carioca prejudica 136 salas comerciais...Em 13 de outubro de 2011, retorno de feriado, um acúmulo de gás provocou a explosão de um restaurante que funcionava no centro do RJ.

O restaurante ocupava o andar térreo de um edifício com

12 andares e

136 salas comerciais.

Desde então o edifício está LACRADO e, segundo a Defesa Civil do RJ,

o edifício não será reaberto em 2011.

Nas 136 salas comerciais funcionavam empresas de contabilidade, advocacia, webdesign, representação comercial, etc...

Esse exemplo mostra que a preocupação não deve ser apenas em empresas grandes.

Todos os escritórios e microempresas que mantinham backup de suas informações foram surpreendidas com a explosão na volta de um feriado mas, bastando adquirir novos PCs, levantaram suas operações no mesmo dia.

Já as empresas que não tinham backup dos dados, mesmo não tendo qualquer ligação com o restaurante, viram seu negócio ruir quando não tiveram mais acesso ao prédio.

Prevenir ainda é melhor que remediar...